Comment encadrer cette nouvelle technologie ?

Comme pour tout projet, il s’agit de répondre à un besoin dans le respect des délais et du budget alloués. Opérationnellement un projet Big Data nécessite une structure, une organisation et des ressources pluridisciplinaires. Ici, le modèle classique du cycle en V est déconseillé. Il faut au contraire construire la solution progressivement, en prévoyant des itérations comprenant des interactions avec les futurs utilisateurs. Les données étant au cœur des attentes, un dialogue permanent avec les utilisateurs des données doit être établi.

Il convient de se poser les questions fondamentales telles que :

- La technologie envisagée respecte-t-elle des standards de normalisation ?

- L’outil envisagé est-il adapté à ce que je veux faire, s’intègre-t-il facilement dans mon paysage actuel ?

- S’agit-il d’une technologie fiable pour les cinq à dix ans à venir ?

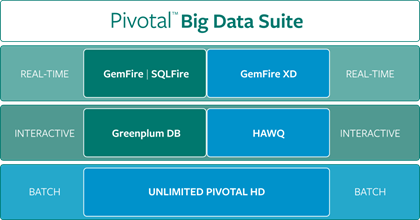

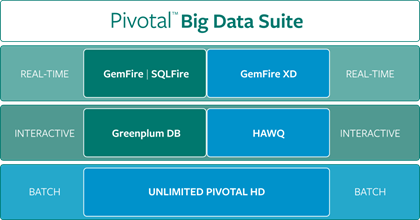

La Fédération EMC a récemment lancé Big Data Suite et Pivotal HD 2.0, la première plate-forme combinant la technologie de framework analytique Open Source Hadoop. Elle intègre une base de données massivement parallèle sur Hadoop (HAWQ) et aussi la technologie de base de données SQL « In-Memory GemFireXD3 ».

1 - La technologie

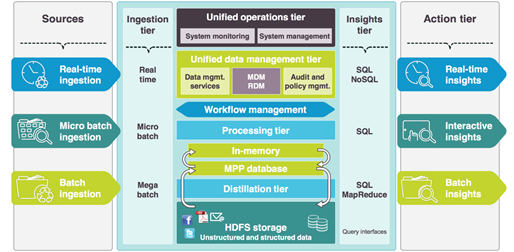

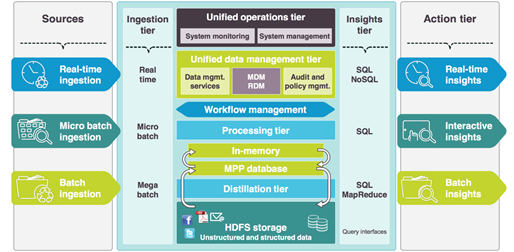

Avec cette intégration, l’objectif de Pivotal est de coupler les capacités innovantes d’Hadoop avec des capacités d’ingestion, de traitement et d’analyse en temps réel et en mémoire. Ceci permet de répondre à la variété des besoins de capture et de traitement des données des entreprises tout en favorisant un écosystème maitrisé autour des projets data comme les outils ETL et BI avec les standards ouverts SQL.

2 - Les outils

Pivotal Big Data Suite inclus la distribution Apache Hadoop 2 via Pivotal Hadoop, permettant d’accoster tous les outils et API de l’écosystème ouvert Hadoop. Elle comprend également des capacités SQL natives sur Hadoop (HAWQ), et propose par le biais de la base massivement parallèle (GreenPlum), une stratégie d’intégration d’Hadoop, typique dans les environnements décisionnels.

Dans tous les cas, les standards ouverts et open source sont au cœur du positionnement de l’offre et permettent de bénéficier d’un écosystème technologique extrêmement riche en compétence. Par exemple SQL, Hadoop, Map Reduce, Hive mais aussi des outils ETL et de reporting. Cela concerne également les domaines de l’analytique prédictive avec l’intégration de solutions telles que SAS ou R.

3 - Les applications centrées autour de la donnée

La Big Data Suite permet de construire un data lake et d’intégrer progressivement mais de manière cohérente et unifiée les différents constituants technologique : big data, fast data, structuré, non structuré, reporting, prédictif, etc.

La stratégie de Pivotal dans les applications et le middleware avec « Cloud Foundry » permet par ailleurs de rendre opérationnel le flux de données dans un périmètre applicatif, et de maximiser l’agilité et l’adoption de ces nouvelles capacités de traitement et d’accès à la données notamment via une Plateforme « As a Service ».

Les facteurs clés de succès

La première chose importante à réaliser est de s’assurer du bien-fondé du projet lui-même. L’étude d’opportunité menée en phase d’avant-projet doit mettre en évidence les apports du projet pour l’entreprise.

Il faut ainsi que le projet :

- Apporte de la valeur au métier de l’entreprise

- Soit générateur d’un avantage concurrentiel

- Soit porté par les directions métiers et la Direction Générale

La disponibilité de ressources adéquates pour ce type de projets constitue un point sensible. Des tensions se font sentir notamment vis-à-vis des scientifiques de données, ces fameux « Data Scientists » aux compétences mathématiques et statistiques pointues. Ces experts sont capables de donner du sens aux données grâce à des modèles mathématiques élaborés, notamment les modèles prédictifs. Des formations initiales spécialisées existent mais le nombre d’étudiants diplômés est insuffisant pour répondre à la demande. On peut aussi parier sur le fait que les outils qui seront proposés à l’avenir seront de plus en plus exploitables par des non-statisticiens.

Cependant, un projet Big Data doit s’accompagner d’une réflexion globale sur la gouvernance des données. La prise de conscience des dirigeants de la valeur des données pour l’entreprise doit être présente. Ensuite la volonté de réussir, le pragmatisme et la mise en place des équipes adéquates permettent à coup sûr d’assurer la réussite de ces projets.

Source de ce document sur ce lien