|

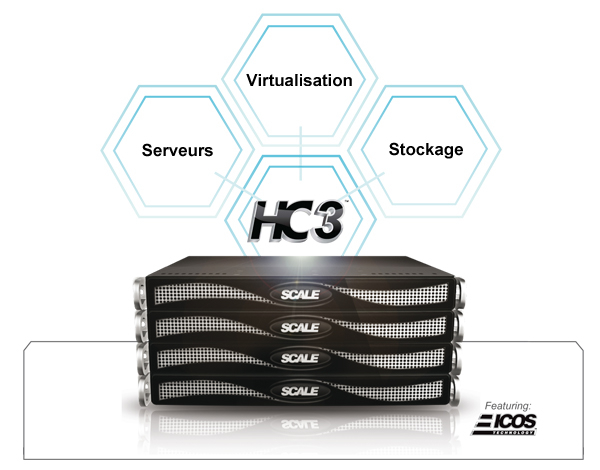

Appelée « HC », la solution multi-primée intègre serveurs, stockage et réseau dans une Appliance en cluster, pilotée par le système d'exploitation « ICOS ™ » (Intelligent Clustered Operating System). |

« HC3 » offre un « Pôle de centre de données » hautement disponible, facile à utiliser et très abordable pour les PME qui n'ont pas encore virtualisé leur environnement. C'est la solution idéale du moment, surtout que selon « CRN Magazine », 70 pour cent des PME n’y sont pas encore passée au vu de la complexité de cette technologie qui regroupe une infrastructure fonctionnelle intégrée et hautement disponible. Grâce à sa simplicité, KVM peut jouer un rôle crucial sur le marché de l’hyper-convergence, avec cette niche encore inexploitée.

Vidéo de présentation de Scale Computing, solution d'hyperconvergence, par Bastien BOBE, responsable technique chez Hermitage Solutions (distributeur exclusif en france).

KVM

KVM est une solution open source Linux conçue pour être installée dans le noyau Linux. KVM a été introduit dans la communauté open source en 2007 comme une réponse aux solutions commerciales de virtualisation de Citrix, VMware et d'autres. Contrairement à leurs homologues, KVM n'est pas un produit facile à utiliser par les généralistes de l’IT. Ceci dit, il est largement utilisé avec ses homologues pour des applications spécifiques dans les petites et les grandes entreprises.

KVM sera entièrement packagé et totalement fonctionnel dans une offre commerciale dédiée à l’hyper-convergence par Scale Computing. Le choix de KVM s’explique et se segmente en trois catégories :

- Technique

- Commerciale

- Stratégique

1 - Les raisons techniques

Prise en charge native pour tous les systèmes d'exploitation invités. Avec un hyperviseur de niveau 1 open source, KVM utilise la virtualisation matérielle (ce qui élimine la nécessité de modifier les systèmes d'exploitation invités) et peut supporter presque n'importe quel système d'exploitation invité dans Linux.

Code efficace et une meilleure performance. Contrairement à VMware, KVM n'est pas un code en masse (Overhead) qui crée un environnement entièrement virtualisé au détriment à la fois de la compatibilité de l'OS invité et de la performance. Au contraire, c’est un module (kernel) ajouté à Linux. En ajoutant ce module au noyau lui-même, toutes les machines virtuelles deviennent un vrai processus standard de Linux et peuvent fonctionner directement et rapidement sur la couche matérielle dans une instance para-virtualisée.

Open Source et flexibilité: Les solutions « fermées » obligent les constructeurs à écrire du code pour leurs propres spécifications et à faire payer des redevances pour les utiliser. Entre autres termes, ces spécifications deviennent des limitations.

Avec VMware, par exemple, un tiers ne peut pas intégrer des couches de stockage propriétaires dans le code. La seule façon de faire « converger » le stockage et les serveurs avec VMware est de le virtualiser au travers d’une Appliance de stockage, comme s'il s'agissait d'un Windows ou un autre système d'exploitation invité et d’utiliser des protocoles de stockage standard pour les I/O entre les serveurs virtuels et les Appliances de stockage.

Les systèmes SAN et NAS ont cependant besoin de performance. Les « abstractions » qui sont trop loin du matériel qui doit les exploiter, génèrent énormément de la latence. Cette « fausse » convergence, appelée VSA (Virtual Storage Appliance) n’apporte pas les performances attendues et amène la plupart des fournisseurs VSA à implémenter dans leur solution du stockage SSD à un coût élevé pour compenser. Ces solutions matérielles explosent malheureusement les budgets et conduisent naturellement la plupart des PME à renoncer à ce type de projet.

2 - Les avantages commerciaux

VMware a été le a premier à commercialiser sa technologie de virtualisation et à changer le monde de l'informatique. Mais il y a une chose qu'il ne peut pas facilement changer cependant, c’est son « business model ». La société dépend des revenus tirés de ses licences, ce qui a d’ailleurs donné naissance à une nouvelle expression familière : la «taxe VMware. Citrix (avec XenServer) et Microsoft (avec Hyper-V) ont un portefeuille plus large de produits qui s'étendent au-delà de la virtualisation et sont, par le fait, moins liés financièrement aux revenus de virtualisation que leur homologue appartenant à EMC.

Avec un hyperviseur de type « marchand », VMware est forcé dans son message marketing de mettre en valeur des fonctionnalités de gestion et non pas seulement la virtualisation. Ces fonctions de gestion sont licenciées sur la base de la mémoire utilisée. Pour les PME, cela signifie payer encore et encore pour les fonctions de gestion virtuelles qui n'étaient pas nécessaires dans leur architecture physique et qui ne le seront peut-être pas dans leur environnement virtuel.

Parce que KVM est un système open source, il n'y a pas de frais de licence. Les fabricants comme Scale Computing peuvent alors implémenter des solutions virtuelles complètes et complexes sans interférer financièrement avec des surcoûts côté licences.

3 – La stratégie pour le client et Scale Computing

Le mot d’ordre, c’est d’être attentif pour ne pas tomber dans le « piège » EMC. La société qui possède VMware est bien connue dans l'industrie pour sa politique commerciale agressive. Partenaires de VMware pour le stockage, les deux entités pourraient développer des solutions convergentes « ficelées » qui nouaient l'avenir de leurs entreprises face à leur concurrence. Il est assez probable qu’EMC créer une version VMware hyper-convergée qui ne fonctionnerait que sur des plateformes de stockage EMC. Tous les autres fournisseurs seraient « hors-course », limitant sévèrement choix pour les fournisseurs, les revendeurs et les utilisateurs finaux en particulier.

Scale Computing et HC3

KVM offre de nombreux avantages techniques et commerciaux et permet de poser les fondations pour Scale HC3 en offrant des avantages réels pour les DSI des PME, en tirant pleinement parti de KVM.

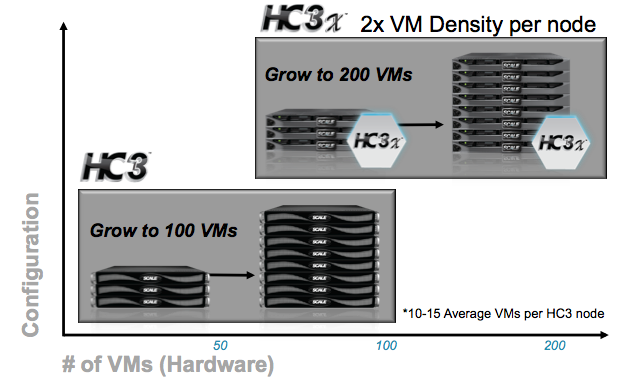

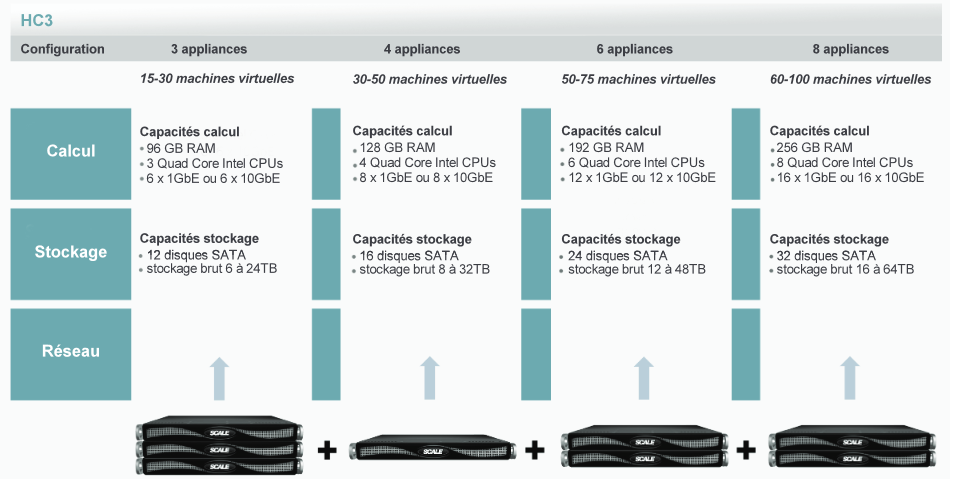

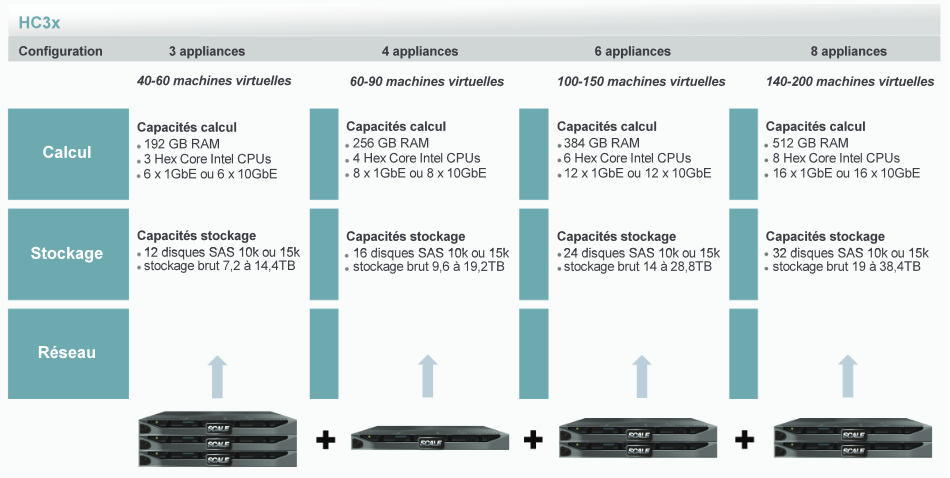

Les infrastructures « Scale HC3 » sont composées d'un minimum de trois nœuds que l'on peut étendre jusqu'à un maximum de huit. Deux modèles d'Appliances composent la gamme, les « HC3 » et les « HC3x » (implémente 2 fois plus de ressources).

Scale Computing annonce les données suivantes pour qualifier les configurations de ses clusters :

- Pour la gamme HC3, un nœud peut héberger en moyenne 10 à 15 VMs (serveurs d'infrastructure) donc un maxumum de 100 VMs pour l'ensemble d'un cluster composé de huit nœuds.

- Pour la gamme HC3x, un nœud peut héberger en moyenne 20 à 30 VMs (serveurs d'infrastructure) donc un maxumum de 200 VMs pour l'ensemble d'un cluster composé de huit nœuds.

Les spécifications techniques

Fonctionnalités de HC :

Haute disponibilité. Avec son système ICOS (Intelligent Clustered. Operating System), un des plus avancé du marché, basé sur les GPFS d'IBM et combiné à KVM, HC fournit une architecture hautement disponible, offrant le mirroring de ses données au travers chaque nœud du cluster. Si un disque ou un nœud du cluster tombe en panne, le système continue à fonctionner.

Dans un environnement de serveurs physiques, une application est liée à un serveur et si l’on perd ce serveur, l’application est immédiatement indisponible et les processus de récupération sont plutôt complexes à mettre en œuvre. La consolidation de plusieurs serveurs physiques en à quelques hôtes virtuels permet de réduire les coûts, mais il faut sécuriser l’ensemble pour minimiser les arrêts de production en cas de panne. Pour faire face à ce risque, les plates-formes de virtualisation offrent des fonctionnalités de basculement de haute disponibilité (HA) qui nécessitent l’implémentation de plusieurs hôtes de virtualisation qui doivent partager un pool de stockage extérieur commun. Ce dernier doit également être hautement disponible.

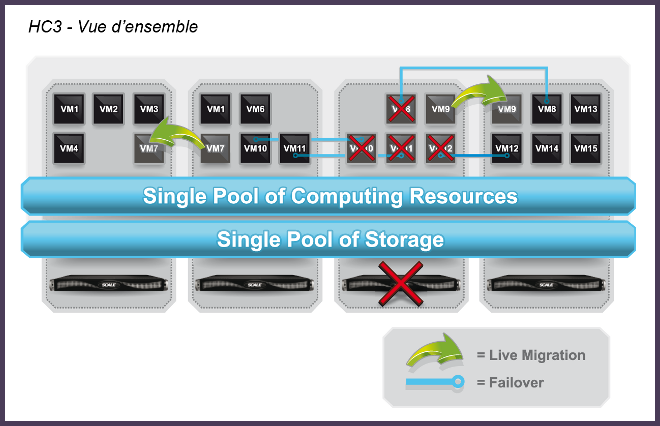

L'architecture du HC est conçue pour gérer les défaillances matérielles des disques et du calcul. Les machines virtuelles et leurs données sont redondantes, en miroir et réparties entre tous les nœuds du cluster pour garantir, en cas de défaillance d'un disque, que les applications qui fonctionnent dans les machines virtuelles restent disponibles avec un accès complet à leurs données. Dans le cas où l’on perd un nœud de du Cluster HC, toutes les machines virtuelles s'exécutant sur ce nœud sont rapidement et automatiquement redémarré sur un autre nœud dans le cluster, en maximisant la disponibilité des applications.

Migration de la machine virtuelle. Avec certains fournisseurs d'hyperviseurs commerciaux, cette fonction est fournie en option. Parce que KVM gère la scalabilité nativement, HC met à disposition cette fonctionnalité sans coût supplémentaire. Les machines virtuelles peuvent être directement migrées vers n'importe quel serveur du cluster en fonction des exigences d'attribution et de performance mémoire de chaque machine virtuelle.

I/O directes et sans Protocoles. Comme mentionné précédemment, les dépendances VSA de l'architecture VMware doivent s’appuyer sur un protocole propriétaire pour que les Appliances de stockage virtuelles puissent communiquer avec les serveurs virtuels. C’est une hérésie technologique en hyper-convergence. Avec HC, un seul pool de ressources de calcul et de stockage est créé, permettant les Entrées/Sorties (I/O) en mode directe. Pas besoin de protocole, la communication entre le pool de ressources de calcul et le pool de ressources de stockage se fait sur le même matériel. La latence est réduite et permet une scalabilité moins coûteuse qui utilise des disques magnétiques de de base plutôt que des SSD plus chères.

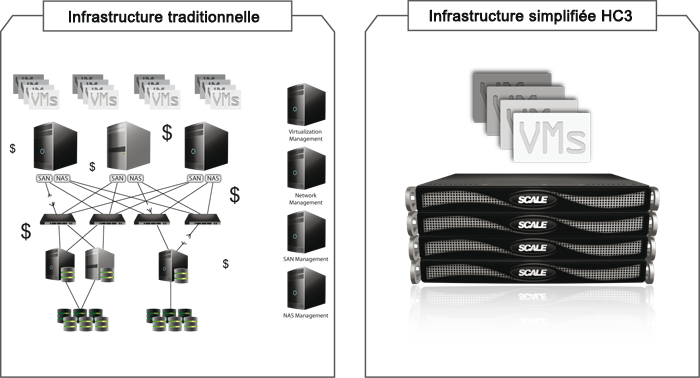

Un seul fournisseur - Une intégration transparente. Avec Scale Computing, l'ensemble des composants, serveur, stockage et virtualisation sont intégrés dans un même boitier, au cœur d’un système d'exploitation simple d'utilisation appelé « ICOS ». Et comme dit Scale Computing, s’il y a quelqu’un à étrangler si quelque chose se passe mal, c’est nous…

Chaque cluster HC dispose d'un pool de ressources, extensible et partagé, pour exécuter les applications. Ils intègrent et équilibrent l’ensemble des ressources CPU, mémoire, les accès au réseau et au stockage et peuvent très facilement s’étendre au fur et à mesure que les besoins grandissent.

Il n'est donc plus nécessaire d'assembler des systèmes de stockage disparates, des serveurs ou hyperviseurs de plusieurs fournisseurs, d’avoir plusieurs consoles de gestion et de configurer les connectivités avec des protocoles réseau et stockage entre les différents systèmes.

Facilité d'utilisation. Infrastructure convergente ne doit pas être synonyme d’architecture schématique avec de nouvelles couches de logiciels de gestion avec ses services associés.

La scalabilité HC offre un environnement IT intégré, simple à comprendre, simple à déployer et simple à gérer. Les intervenants peuvent alimenter les nœuds, configurer des adresses IP pour construire un cluster, puis créer leur première machine virtuelle en utilisant la mémoire partagée et les ressources de calcul du cluster HC.

Faible coût total de possession. Scale’s HC va permettre de faire des économies d’acquisition substantielles en évitant la gestion séparée des serveurs, du stockage et des logiciels de virtualisation. Scale’s HC minimise aussi le câblage et le switching. Les coûts sont donc consolidés en ce qui concerne les logiciels de virtualisation, les serveurs et le stockage et le coût d'un SAN est évité. En conséquence, et grâce à son architecture Scale-out, le coût pour augmenter la taille et la performance de l'environnement virtuel est granulaire et abordable.

En finalité, la solution apporte la simplicité d’utilisation avec le bon niveau de fonctionnalité pour les entreprises. Scale Computing estime que cette mesure permettra de réduire le temps de gestion de 75 pour cent par rapport à la virtualisation traditionnelle.

Voici le lien pour télécharger le contenu de ce billet au format PDF et en anglais.

Vous pouvez télécharger un document en anglais sur ce lien qui décrit la technologie, les concepts et la théorie de fonctionnement du système HC3 de Scale Computing (Hyper-converged Compute Cluster) ainsi que le concept sa nouvelle couche de stockage SCRIBE* introduit avec HyperCore. Je n’ai pas encore trouvé le temps de le traduire. Téléchargez le document sur ce lien.

* SCRIBE est la nouvelle gestion du stockage de Scale Computing. Un peu similaire à Nutanix ou Virtual SAN, cette gestion va apporter un facteur de réplication de la donnée sur plusieurs nœuds du cluster (s'appuie sur la technologie GPFS d'IBM) de manière à assurer à la fois le niveau requis de redondance (équivalent d'une approche RAID 10), mais aussi une agrégation des capacités d'E/S et de débit sur tous les disques de la grappe.