L’architecture de stockage en réseau déterminée il y a quinze ans pour servir les besoins des serveurs physiques est aujourd’hui bien trop chère et complexe à gérer pour adresser le monde virtualisé.

Par manque d’alternatives robustes et éprouvées, les équipes informatiques sont contraintes d’utiliser des solutions traditionnelles qui ne suivent pas le rythme des machines virtuelles qui se déplacent, se multiplient rapidement et demandent de plus en plus de performance et de capacité.

Nutanix Complete Cluster est une architecture scale-out unique sur le marché, car elle contient à la fois la puissance de calcul et l’espace de stockage permettant aux entreprises de virtualiser leur centre de donnée sans utiliser de baie de stockage en réseau (SAN ou NAS) dissociée des serveurs. Développé pour servir les machines virtuelles, le cluster Nutanix simplifie radicalement l’architecture via l'usage de ses blocs d'infrastructure très denses contenant processeurs, mémoire, médias de stockage et fonctionnant en cluster extensible selon les besoins.

Résultat: un niveau de disponibilité maximum, une performance optimale qu'elle que soit la taille de l'environnement virtuel, une baisse drastique des coûts d'infrastructure et une grande simplicité de mise en œuvre.

Voir ces deux billets « La gestion du stockage chez Nutanix » et « Nutanix et son stockage » sur le blog.

Introduction

Limitations des architectures actuelles

Les entreprises, pour la plus grande majorité, bâtissent leurs plateformes de virtualisation sur la base d’un modèle traditionnel de serveurs connectés à une baie de stockage à travers un réseau, modèle qui se prête mal aux évolutions des environnements virtuels. En effet, il est très fréquent de constater des problèmes de dégradation des performances avec l’accroissement du nombre de VM hébergées par ce type d’architecture. C’est la première raison pour laquelle les grands acteurs du Cloud n’utilisent pas ce modèle serveurs-réseau-stockage pour servir les machines virtuelles qu’ils hébergent. La seconde raison est que dans un modèle traditionnel, le stockage en réseau est devenu la source principale de coût et de complexité au sein des infrastructures virtuelles.

Le modèle de stockage en réseau fonctionne bien pour des serveurs physiques qui servent des applications relativement statiques. La virtualisation et, plus récemment, le Cloud Computing ont rendu les Datacenters extrêmement dynamiques : les machines virtuelles sont créées à la demande, se déplacent sur différents serveurs et dépendent complètement des ressources partagées. Ces caractéristiques rendent extrêmement complexe la gestion des machines virtuelles et de l’infrastructure physique sous-jacente.

Conséquence directe de la facilité de création des VM : les volumes de données augmentent très rapidement au sein des data-centres. Dans les entreprises, de nouvelles initiatives comme la virtualisation des postes de travail accentuent encore cette tendance. Le surcroît d’activité lié à la gestion des infrastructures de virtualisation n’est plus absorbable par beaucoup d’entreprises. Celles-ci externalisent de plus en plus leurs machines virtuelles chez des sociétés de services, qui se retrouvent à gérer un nombre encore plus gigantesque de machines virtuelles, et à implanter des data-centres de en plus capacitifs pour répondre à la demande. Le nombre croissant de machines virtuelles exerce une pression de plus en plus forte sur les architectures traditionnelles qui connectent les moyens de calcul aux espaces de stockage via un réseau multicouches, particulièrement en termes de performance, temps d’administration et budget d’investissement. La solution idéale serait donc une architecture basée sur des briques très simples à installer et à remplacer, dont la performance augmente à l’infini en fonction des besoins, et qui réduise drastiquement les dépenses en matériels, logiciels, espace occupé et consommation électrique.

L’émergence des disques SSD (solid-state) est une autre tendance qui agrandit le fossé entre les serveurs et les systèmes de stockage. L’usage de disques SSD qui sont entre 100 fois et 1000 fois plus rapides que les disques traditionnels vont accroitre les goulots d’étranglement et la complexité du réseau stockage si les machines virtuelles doivent y accéder à travers un réseau. De nombreux acteurs du stockage SAN/NAS ajoutent désormais les disques SSD à leurs solutions, pour un budget conséquent. Ce type de solution nécessite également des investissements supplémentaires sur le réseau, afin de délivrer la bande passante nécessaire à l’exploitation de ce tiers de stockage pourtant déjà onéreux. Sur cet aspect, la solution idéale permettra aux machines virtuelles d’accéder directement à ces SSD en local pour une performance maximale, tout en supportant les fonctionnalités primordiales de déplacement de VM et de haute disponibilité.

L’approche Google

Google et d’autres entreprises majeures de l’ère du Cloud comme Amazon, Yahoo et Microsoft (Azure) ont pris conscience qu’une approche basée sur du stockage en réseau ne pourrait pas fonctionner pour leurs data-centres. Ils ont donc développé des solutions logicielles (par exemple le Google File System) qui peuvent fédérer un très grand nombre de serveurs de commodité incluant du stockage local dans un cluster unique.

Cette approche a permis à Google de construire une infrastructure convergée de calcul et de stockage utilisant des serveurs contenant du stockage local comme brique de base. Le File System de Google exploite un cluster de serveurs et crée un espace de stockage unique qui peut être accédé par toutes les applications qui s’exécutent sur un des serveurs du cluster. La particularité de ce type d’architecture est que le système cherche constamment à rapprocher géographiquement l’exécution de l’application et les données utilisées, ainsi une majorité des échanges s’effectuent localement dans le serveur afin d’éviter l’utilisation du réseau. Le niveau de performance est donc optimal grâce à l’élimination des problèmes de latence et de congestion.

Cette architecture permet également d’obtenir un très haut niveau de disponibilité pour les applications en masquant complètement les pannes matérielles au niveau des disques et des serveurs. Le File System Google a permis à Google de construire des data-centres évolutifs à l’extrême tout réduisant les coûts de moitié et en levant les limites de performance constatées sur des architectures serveurs-réseau-SAN/NAS.

Pour les besoins des entreprises, Nutanix a adopté une approche « scale out » similaire pour développer une infrastructure de calcul et de stockage prévue dès sa genèse pour l’hébergement de machines virtuelles en entreprise. A l’origine de Nutanix, on retrouve l’équipe d’architectes et développeurs à l’origine du Google File System, les architectes de l’infrastructure Big Data de Facebook ainsi que d’autres talents issus des domaines du Cloud, de la virtualisation, de l’optimisation des performances sur les systèmes de stockage.

L’architecture de Nutanix Complete Cluster

Principes fondamentaux

La solution Nutanix Complete Cluster a été développée à partir d’une feuille blanche pour résoudre les problématiques liées au stockage pour les machines virtuelles en construisant un système qui tire parti des dernières avancées en terme d’architecture système, et de technologies matérielles et logicielles. Il y a trois piliers clés dans l’architecture Nutanix.

Infrastructure distribuée

L’architecture Nutanix est similaire à celle de Google car c’est une infrastructure distribuée, ou « scale out » au niveau des moyens de calcul et de stockage qui élimine le besoin en système de stockage en réseau. Nutanix puise dans les meilleurs pratiques et fonctionnalités de l’environnement Google pour délivrer une solution optimisée pour la virtualisation en entreprise. A l’inverse du Google File System qui est une solution customisée pour les applications internes de Google (recherche, Gmail, etc..), Nutanix fournit une solution qui sert toutes les applications à partir du moment où elles sont virtualisées. En plus de ses facultés à distribuer l’infrastructure, la solution dispose de fonctionnalités embarquées identiques ou meilleures que celles fournies dans les solutions de stockage classiques du marché.

Ceci inclut des fonctions de haute disponibilité, réplication, snapshot, backup, reprise d’activité, compression en ligne et post process, thin provisioning, etc…

Voir le billet « NDFS, le système de fichiers distribué de Nutanix » sur le blog

Virtualisation

La solution Nutanix a été pensée pour les machines virtuelles, donc elle supporte nativement toutes les fonctions des hyperviseurs, au même titre que les solutions de stockage centralisées. Ceci inclut entre autre la migration en ligne de machines virtuelles et la fonction de haute disponibilité (HA). De plus, comme l’architecture Nutanix est consciente de l’environnement virtuel, elle résorbe les limitations des solutions traditionnelles qui sont optimisées pour fonctionner avec des serveurs physiques.

Par exemple, alors que l’unité de gestion est la machine virtuelle du côté système, du côté stockage l’unité est traditionnellement la LUN. Quand une LUN est partagée par de nombreuses VM, il devient de plus en plus difficile d’effectuer des opérations sur le stockage, telles que la sauvegarde, la reprise après incident, les snapshot par machine virtuelle. Cela devient également très compliqué d’identifier les causes des dégradations de performance au sein d’un environnement fortement mutualisé à cause de la séparation entre serveurs et stockage. L’architecture Nutanix annule complètement ces contraintes et permet à gérer le stockage avec la VM pour unité de gestion.

Solid-State Drives

L’architecture Nutanix a été développée pour tirer le meilleur parti des disques solid-state drives les plus performants du marché. Il est important de noter que les systèmes de stockage traditionnels ont été pensés pour exploiter des disques mécaniques et l’exploitation de disques SSD de manière efficace s’avère très compliquée pour eux, car le mode d’accès aux données est complètement différent avec les disques SSD. Les disques durs doivent gérer des rotations et optimiser la latence des recherches, les disques SSD n’ont pas ces limitations physiques. Cette différence entre les deux médias induit que le logiciel de contrôle doit être paramétré différemment pour tirer le maximum de performance des disques SSD.

On ne peut pas simplement utiliser un logiciel prévu pour des systèmes à disques durs et espérer qu’il fonctionnera efficacement avec des disques solid-state. La solution Nutanix fédère les disques SSD du cluster pour stocker les données accédées fréquemment. Par exemple, les métadonnées et les données « chaudes » du stockage primaire, sont stockées au sein de ce cache distribué pour la haute performance et persistant pour un recouvrement rapide des données. Pour maximiser le gain en performance des SSD, la solution Nutanix :

- Réserve les disques SSD pour les fonctions gourmandes en I/O

- Inclus des technologies d’optimisation d’espace utilisé pour permettre à une grande capacité d’espace virtuel d’être stocké sur une petite quantité d’espace physique

- Migre automatiquement les données « froides » ou rarement utilisées vers des disques durs capacitifs, et permet aux administrateurs systèmes de by passer les SSD pour les machines virtuelles dont la criticité est faible.

Voir le billet « La donnée et ses chemins I/O chez Nutanix » sur le blog

Description de l’architecture

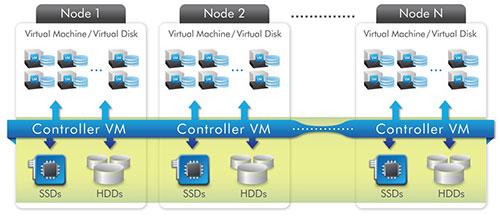

La solution Nutanix Complete Cluster est un cluster distribué de nœuds haute performance, chacun exécutant un hyperviseur standard et contenant des processeurs, de la mémoire, du stockage local dont des disques SSD et des disques durs. Chaque nœud héberge des machines virtuelles comme un serveur hôte de virtualisation standard. De plus, le stockage local de chaque nœud est virtualisé au sein d’un espace unifié par Nutanix Scale-Out Converged Storage (SOCS) (Figure1). En effet, SOCS agit comme un SAN avancé qui utilise les SSD et disques durs locaux de tous les nœuds pour stocker les données des machines virtuelles. Les machines virtuelles qui tournent sur le cluster écrivent les données vers SOCS comme si elles écrivaient vers un SAN. SOCS est conscient des VM de l’environnent et leur fournit des fonctionnalités avancées de gestions des données. Il amène les données au plus proche des machines virtuelles en les stockant localement dans le système qui exécute la VM, ce qui donne les meilleures performances pour un prix réduit. Afin d’assurer la haute disponibilité du système les données sont également répliquées au sein du cluster. La solution Nutanix Complete Cluster s’étend horizontalement de quelques nœuds à un très grand nombre de nœuds, permettant aux entreprises d’étendre leur infrastructure lorsqu’elles en ont besoin.

Figure 1: Nutanix Scale-Out Converged Storage Architecture

Avec la solution Nutanix Complete Cluster, toutes les fonctionnalités de virtualisation, incluant la haute disponibilité et le déplacement de VM, continuent de fonctionner de manière optimale. Les administrateurs créent des machines virtuelles en utilisant leurs procédures habituelles. Nutanix SOCS fournit le stockage pour ces machines virtuelles sous forme de disques virtuels, ou vDisks, qui se présentent comme des périphériques iSCSI standards.

Voir le billet « Nutanix - Software-Defined Controller Architecture » sur le blog

Nutanix Scale-Out Converged Storage – Composants clés

L’élément clé de l’architecture Nutanix est SOCS - une couche d’abstraction propriétaire permettant la convergence et la distribution de l’infrastructure qui fournit un ensemble unique de fonctionnalités :

- Il est réellement convergé avec les moyens de calcul. Les VM et SOCS coexistent au sein du même cluster.

- Il est conscient des VM qui l’environnent. SOCS fournit du stockage VM par VM et peut identifier les I/O liés à chacune d'entre-elles.

- Il peut s’étendre de 3 nœuds à un nombre très importants de nœuds.

- Il intègre nativement l’exploitation optimale des disques solid-state drives.

- Il permet une très haute disponibilité du cluster, rendant la solution insensible aux pannes de disques et de serveurs.

- Il délivre une très haute performance en s’assurant que les I/O s’effectuent en local, en exploitant idéalement les SSD et en utilisant une série de fonctionnalités d’optimisation propres à Nutanix.

- Il fournit des fonctionnalités uniques d’optimisation de la capacité de stockage utilisée.

SOCS fonctionne grâce aux composants suivant:

n-Way Controller Cluster

Alors que les systèmes de stockage SAN traditionnels présentent typiquement 1, 2, 4 ou 8 contrôleurs, un n-node Nutanix Complete Cluster a n contrôleurs (Figure 2). Chaque nœud du cluster exécute une machine virtuelle spéciale, appelée « Controller VM ». Cette machine virtuelle agit comme un contrôleur virtuel pour SOCS. Toutes les VM « Controller VM » dans un cluster communiquent les unes avec les autres pour former un seul système distribué. A la différence des systèmes SAN/NAS traditionnels, qui sont limités à un petit nombre de contrôleurs fixes, cette architecture continue de s’étendre à mesure que des nœuds sont rajoutés au cluster.

Figure 2: Nutanix Scale-Out Controller VM Architecture

Heat-Optimized Tiering Cache (HOTcache)

HOTcache est un cache haute performance fonctionnant en complémentarité des SSD au sein de chaque nœud du cluster. Quand une VM guest écrit une donnée, cette donnée est en premier lieu écrite dans HOTcache et ensuite, en tache de fond, est transférée vers SOCS. HOTcache utilise une disposition séquentielle des données pour fournir les meilleures performances même en cas de charges applicatives séquencées de manière aléatoire par un ensemble de VM. HOTcache garde une copie de la donnée sur un disque SSD local et une autre copie sur un autre nœud afin qu’il n’y ait pas de perte de donnée même en cas de perte d’un nœud.

Service de distribution des Meta data (Medusa)

Avec les systèmes de stockage traditionnels, les contrôleurs deviennent souvent le goulot d’étranglement à mesure que la capacité du système augmente. Une des principales raisons à ce problème est que le stockage des Meta data s’effectue sur les contrôleurs. Les systèmes traditionnels évoluent jusqu’à un petit nombre de contrôleurs, donc lorsque le nombre de machines virtuelles augmente, la charge I/O par contrôleur augmente également.

Medusa, est un service de distribution des Meta datas dans le cluster qui garantit la meilleure évolutivité et réplique les données sur plusieurs nœuds pour la tolérance aux pannes. Ce service est hautement disponible et peut tolérer des pannes de plusieurs modules. En comparaison, les solutions de stockage traditionnelles dépendent de quelques contrôleurs et ne peuvent pas tolérer les pannes de plusieurs modules sans impact sur la production.

Service de maintenance pour les données distribuées (Curator)

Le service de maintenance pour les données distribuées, Curator, est une architecture logicielle basée sur MapReduce et conçue pour exécuter en tâche de fond des opérations de gestion de la donnée de manière massivement parallèle. Ces opérations incluent :

- Migration des données froides vers des tiers plus capacitifs (pour le Heat-Optimised Tiering)

- Collection des résidus liés aux données effacées

- Vérification de la consistance des données via checksums de routine

- Réplication des données en cas de panne de disques ou de nœud

- Rééquilibrage des données en cas d’ajout ou suppression de nœud

- Migration des données pour permettre l’accès local aux données quand une VM se déplace d’un nœud vers un autre

FlashStore

FlashStore est le stockage persistant basé sur les technologies Flash fourni par l’agrégation des SSD au sein de chaque nœud du cluster. La donnée est d’abord écrite sur FlashStore et ensuite déplacée vers DiskStore lorsqu’elle devient « froide ». Lorsque des données « froides » redeviennent « chaudes », elles sont replacées dans FlashStore. Pour les vDisks qui servent des VMs à la priorité faible, les administrateurs ont l’option de ne pas utiliser FlashStore.

DiskStore

DiskStore est le tiers de stockage SATA de grande capacité réparti sur le cluster. DiskStore fournit une grande capacité de stockage pour les données froides. Le Heat-Optimising-Tiering (HOT) de Nutanix combine Flashstore et DiskStore pour délivrer à la fois une performance maximale et une grande capacité de stockage à faible coût.

Fonctionnalités clés

Nutanix Complete Cluster n’élimine pas seulement le besoin de stockage en réseau mais fournit également une très haute disponibilité, performance et des fonctionnalités avancées de gestion des données. Les fonctionnalités clés sont décrites ci-dessous.

Optimisation de capacité

Nutanix QuickClone

Nutanix permet aux administrateurs de déployer rapidement de nouvelles machines virtuelles en utilisant sa fonctionnalité QuickClone. Les QuickClones sont des snapshots modifiables qui se comportent comme des vDisks standards – les administrateurs peuvent y rattacher des VM, écrire des données dessus et même en faire un autre snapshot. Cette fonctionnalité est très utile pour déployer de nouveau postes de travail virtuels, créer un environnement de test et développement copié à partir de bases de données de production, et pour tout autre scénarios nécessitant des clones sans une duplication des données. Ce système supporte également les snapshots en read-only pour les besoins de sauvegarde.

Nutanix Thin Provisioning

Le stockage des machines virtuelles est provisionné en mode Thin provisioning dans le système Nutanix. Les administrateurs peuvent définir la capacité d’un vDisk mais le stockage physique est alloué seulement lorsque le besoin réel le nécessite. Bien sûr, s’ils le souhaitent, les administrateurs peuvent paramétrer une réservation qui garantit la quantité de stockage pour un ensemble de vDisks.

Nutanix Compression

La solution Nutanix complete cluster intrègre nativement la possibilité de faire de la compression in-line des données, et en option la compression post process. La compression permet de multiplier l’espace de stockage utile entre x 2 et x 4.5. Lorsque la compression est effectuée in-line, il y a une pénalité au niveau utilisation des processeurs, donc en général cette fonctionnalité est activée pour des clusters de test ou de reprise d’activité. Dans le cas de la compression post-process, la tâche s’effectue en tache de fond, et progresse chaque fois que la puissance processeur est libérée par les machines virtuelles. Donc pour un cluster de production, il est préférable d’utiliser la compression post process afin d’assurer une priorité aux machines virtuelles sur les ressources processeurs.

Nutanix Elastic Deduplication

Nutanix a implémenté une technologie de déduplication unique au monde qui démontre la nature réellement convergée du système. Faisant l’objet de brevets déposés, cette fonctionnalité s’applique sur l’ensemble des tiers de stockage à savoir le cache en mémoire et SSD ainsi que le stockage primaire sur disque.

A la différence des systèmes de déduplication in-line ou post process présents sur le marché, le système ne dé-doublonne pas à partir d’une lecture des blocs de données. Lire les données implique une grande consommation d’IOPS dans les systèmes de déduplication post process, ou une grande consommation de puissance processeur pour les systèmes de déduplication in-line. Le système Nutanix, à contrario, va générer une empreinte (identifiant unique) pour chaque bloc de donnée écrit, immédiatement après l’acquittement de l’écriture, ce qui permet d’identifier les blocs de données sans impact sur les performances en écriture.

La base d’empreintes permet dans un second temps de dé-dupliquer le cache en lecture puisqu’un bloc de donnée unique sera monté une seule fois en cache au niveau RAM ou SSD. Cette fonctionnalité permet de maximiser la quantité de données exploitées directement dans le cache pour de meilleures performances.

Enfin, en tâche de fond, le système Nutanix peut re-parcourir la base d’empreinte pour dé-dupliquer les données sans parcourir les blocs de donnée, ce qui permet d’optimiser l’espace de stockage et regagner jusqu’à 90% de l’espace utile. Ce gain d’espace est obtenu sans consommer les IOPS d’une déduplication post-process traditionnelle.

Nutanix Converged Backup

La fonctionnalité Converged Backup fournit des fonctionnalités de sauvegarde instantanée et restauration pour les vDisks. Plusieurs mois de sauvegarde peuvent être conservés dans le système sans nécessiter une solution de sauvegarde externalisée. Quand une reprise d’activité est nécessaire, les administrateurs peuvent restaurer instantanément un vDisk à partir de n’importe lequel de ses backups. Pour les clients qui souhaitent externaliser leur sauvegarde, la solution Nutanix est compatible avec les outils tiers standards du marché.

Simplicité d’administration

Déploiement simplifié

La solution Nutanix Complete Cluster est plug-and-play et contient tous les matériels et logiciels nécessaires pour accueillir un très grand nombre de serveurs virtuels et de postes de travail virtuels. Les administrateurs peuvent l’installer et commencer à créer des machines virtuelles en l’espace de quelques minutes. Le rajout de nœuds permettant d’augmenter la capacité d’un cluster est complètement automatisé et s’effectue en deux clics dans l’interface d’administration.

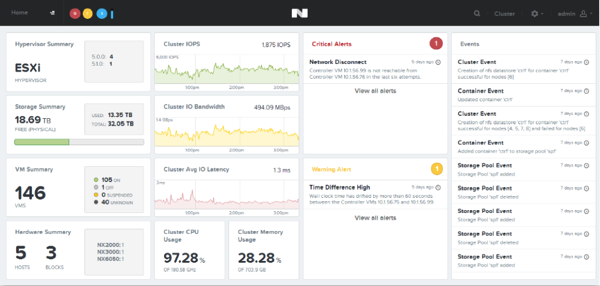

Interface utilisateur de nouvelle génération

Nutanix PRISM est une interface intuitive développée en HTML5 qui permet aux administrateurs d’avoir une vue complète des ressources de calcul et de stockage du cluster. Elle leur permet de réaliser des opérations de trouble shoot sur des VM très simplement en leur permettant de relier chaque VM à des ressources physiques au sein du système.

Nutanix Complete Cluster fournit également une interface CLI pour le management ainsi qu’une API REST et une MIB SNMP pour s’interfacer avec les outils de gestion existants..

Nutanix Scale-out Converged Storage (SOCS)

Nutanix SOCS permet d’éviter la gestion d’un système complexe de stockage en réseau, automatise les tâches et rend beaucoup plus simple la gestion d’environnements virtuels de toutes tailles.

Conformité avec les standards IT

Bien que Nutanix Complete Cluster permette la convergence d’infrastructure, il continue de supporter les outils et interfaces standards du marché que les départements informatiques utilisent. Par exemple, les nœuds hébergent des hyperviseurs standards du marché (tels que VMware ESXi, Microsoft Hyper-V et KVM) et toutes les procédures et outils logiciels qui fonctionnent avec ces hyperviseurs continueront de fonctionner avec Nutanix. De la même manière, les vDisks sont des périphériques iSCSI standards connectés aux VM via un initiateur iSCSI standard dans l’hyperviseur. En s’appuyant sur des interfaces complètement standardisées, le cluster Nutanix peut s’intégrer sans difficulté dans l’écosystème IT existant des entreprises.

Performance et évolutivité

Solid-State Drives

Nutanix Complete Cluster a été développé avec l’utilisation de disques SSD à l’esprit. Les SSD pour serveurs intégrés inclus dans la solution fournisse de meilleures performances que les SSD au sein des systèmes de stockage traditionnels car ils évitent les problèmes de congestion et de latence induits par du stockage en réseau. Les systèmes traditionnels sont bien souvent limités par la quantité de Meta data qu’ils peuvent accueillir au sein du cache des contrôleurs. Dans un cluster Nutanix, les SSD sont utilisés à la fois pour les données des VM et pour stocker les Meta data de SOCS pour un accès plus rapide. Stocker des Meta datas riches sur SSDs permet à SOCS de fournir des fonctions avancées de gestion des données. Enfin, étant donné l’architecture Scale-out du cluster Nutanix, la capacité SSD du système grossit en même temps que le nombre de nœuds de calcul.

Nutanix Heat-Optimize Tiering (HOT)

Au sein d’un cluster Nutanix, un vDisk peut être alloué à un mix de disques SSD et SATA. Afin de s’assurer que seules les données de grande valeur restent sur les SSD, SOCS déplace les données froides vers les disques SATA de grande capacité en tâche de fond grâce à la fonctionnalité HOT.

Nutanix Elastic Deduplication

La technologie de déduplication Nutanix est utile à la fois pour optimiser l’espace de stockage mais aussi pour obtenir de meilleures performances. En effet, la déduplication s’effectue sans impact sur les performances mais en plus elle permet d’optimiser la quantité de données contenues dans le cache soit le tiers le plus performant du système.

Seuls les blocs de données uniques étant montés en cache, dans un contexte, ou de nombreux blocs de données seraient identiques entre les machines virtuelles (VDI par exemple), la totalité des données chaudes fonctionnent depuis le cache du système pour une performance décuplée.

Evolutivité

Le Cluster Nutanix est pensé pour évoluer depuis 3 nœuds jusqu’à un très grand nombre de nœuds (pas de limite). Chaque aspect de la solution a été développé avec en tête les besoins d’évolutivité des data-centres virtualisés d’aujourd’hui. A titre d’exemple, il n’y a pas de notion de maitre qui centraliserait les Meta data au sein du système. La couche de Meta data est, elle aussi, distribuée à travers l’ensemble du cluster, éliminant les points de contention habituels sur les systèmes Scale-out. De plus avec un contrôleur SOCS par nœud, le nombre de contrôleurs au sein du système peut être bien supérieur à celui d’un système de stockage traditionnel contenant seulement quelques contrôleurs. Ces innovations majeures sur le design permettent au système de commencer petit et de s’étendre massivement au moment où le besoin se présente.

Haute disponibilité

Nutanix Cluster RAID

Nutanix Complete Cluster est un système Scale-out très hautement disponible, sans aucun single point of failure. Grâce à l’utilisation du Cluster RAID Nutanix, les données sont réparties en blocs sur les disques d’un nœud afin d’améliorer les performances et répliquées à travers le cluster pour garantir la haute disponibilité. Ceci permet de délivrer une très haute disponibilité aux machines virtuelles même en cas de perte de disques ou de serveurs.

Redondance, changement de pièces, upgrade

Un cluster Nutanix est prévu pour résister à la perte successive de plusieurs composants sans perte de service. Chaque bloc de donnée étant écrit 2 fois dans la grille, lors de la perte d’un disque ou d’un nœud, le système peut continuer de servir les machines virtuelles actives grâce au réplica de donnée.

Dès que le système détecte que certains blocs de données ne sont présents qu’à un seul exemplaire (lors de la perte d’un nœud par exemple), le système s’auto-cicatrise en régénérant un réplica pour chacun de ces blocs de données. L’opération est très rapide car tous les nœuds du cluster travaillent à cette reconstruction. Une fois l’opération terminée le système est à nouveau en position de tolérance aux pannes.

Concernant le changement de pièces, les composants principaux (SSD, Disques, Alims) sont extractibles à chaud sans arrêt de production.

Enfin lors d’une upgrade des contrôleurs de stockage virtuels, Nutanix fournit une procédure automatisée qui permet d’upgrader les contrôleurs virtuels un par un sans impact sur les machines virtuelles en production.

Service de distribution des Meta data (Medusa)

Medusa est un service qui distribue les Meta data au sein du cluster et réplique les données sur de multiples nœuds pour garantir la tolérance aux pannes. Ce service permet d’atteindre un très haut niveau de disponibilité pour un data-centre virtualisé si on le compare aux solutions traditionnelles qui s’appuient sur quelques contrôleurs de stockage pour la redondance et la performance.

Nutanix Instant vDisk Motion

La capacité à migrer une VM en production d’un serveur hôte à un autre est une fonctionnalité très puissante fournie par les hyperviseurs standards du marché.

Jusqu’à présent, les entreprises ont pu profiter de cette fonctionnalité uniquement via l’usage d’un stockage centralisé et accédé via le réseau. D’ailleurs beaucoup d’entreprises ont implémenté ces solutions de stockage en réseau uniquement pour permettre le déplacement de VM à chaud et la haute disponibilité.

Dans un cluster Nutanix, le déplacement de VM à chaud fonctionne parfaitement bien qu’il s’agisse d’une infrastructure convergée qui utilise du stockage local. Les vDisks au sein du système sont des entités logiques complètement mobiles. Cette notion est primordiale pour la fonction Nutanix Instant vDisk Motion qui permet de déplacer rapidement un vDisk d’un nœud à un autre, quand nécessaire.

Sauvegarde et restauration

La faculté de sauvegarder et restaurer l’environnement sur un site de reprise est clé pour la stratégie de protection des données en entreprise. Nutanix Complete Cluster permet nativement d’effectuer des sauvegardes de données internalisées au cluster et d’effectuer des réplications entre cluster. Pour l’externalisation complète des sauvegardes, la solution et est compatible avec l’API vStorage de VMware pour la protection des données (VADP). Ceci permet une sauvegarde et restauration complète et fonctionnelle des machines virtuelles, à travers l’intégration avec les outils du marché compatibles VADP.

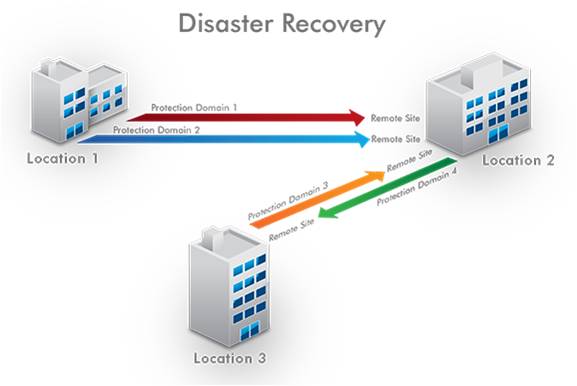

Reprise d’activité

Nutanix propose une fonctionnalité de réplication couplée avec une procédure de reprise d’activité automatisée. Cette fonctionnalité permet en un clic de lancer la procédure de reprise d’activité incluant le réenregistrement des machines virtuelles dans l’hyperviseur du site de reprise dans l’état ou elles étaient lors de la dernière réplication. La procédure de retour arrière s’effectue en un clic également ce qui facilite les opérations de bascule planifiées ou non. Le nombre de sites inclus dans l’architecture PRA est illimité et le niveau de granularité de cette protection est la machine virtuelle (et non pas la LUN).

Nutanix Maintenance et Monitoring

Chaque système Nutanix propose par défaut une fonctionnalité « call-home » qui permet à nos équipes supports de monitorer la plateforme et d’assurer une maintenance proactive sur le système. Cette fonction est désactivable ou ré-orientable vers l’équipe informatique du client, si une communication vers l’extérieur n’est pas souhaitée. Les ingénieurs Nutanix effectuent le support de la solution Nutanix à distance ainsi que de l’hyperviseur choisi par le client (VMware ESX, Microsoft Hyper-V, KVM). Le changement de pièce est effectué sur site par un ingénieur sous-traitant certifié Nutanix.