NOTA : Ce billet est repris du site Technet de Microsoft (voir lien de la source en fin d'article)

Notez que, pour les environnements de production, nous recommandons d’opter pour une offre matérielle/logicielle définie par le logiciel Windows Server comprenant des outils et procédures de déploiement de production. Ces offres sont conçues, assemblées et validées pour répondre aux exigences de Microsoft vis-à-vis des environnements de cloud privé et contribuent ainsi à garantir un fonctionnement fiable. Les offres définies par le logiciel Windows Server seront mises à disposition plus tard cette année. Consultez les mises à jour !

Si vous voulez évaluer les espaces de stockage direct dans Windows Server 2016 sans investir dans du matériel, vous pouvez utiliser des machines virtuelles Hyper-V, comme décrit dans Testing Storage Spaces Direct using Windows Server 2016 virtual machines (Test des espaces de stockage direct avec des machines virtuelles Windows Server 2016).

Conseil

Avant de déployer des espaces de stockage direct, il est recommandé de lire rapidement ce document pour vous familiariser avec l’approche globale, afin d’avoir une idée des notes importantes associées à certaines étapes et connaître les ressources de support et la documentation supplémentaires.

Ce guide inclut des instructions expliquant comment installer et configurer les composants d’un système hyper-convergé à l’aide de Windows Server 2016 avec l’option d’installation Serveur avec Expérience utilisateur ou l’option d’installation minimale.

Le fait de déployer un système hyper-convergé peut être divisé en trois phases générales :

Vous pouvez travailler sur ces étapes, quelques unes à la fois ou en une seule fois. Toutefois, elles doivent être exécutées dans l’ordre. Après avoir présenté certaines conditions préalables et la terminologie, ce guide décrit plus en détail chacune des trois phases et fournit des exemples.

Vue d’ensemble de la solution

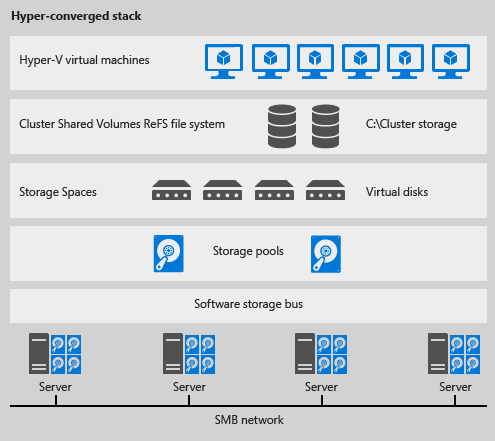

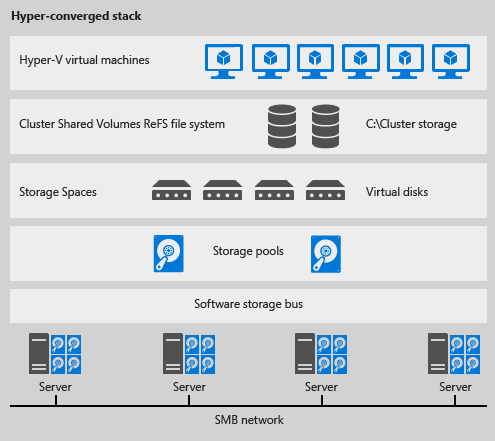

Dans la configuration hyper-convergée décrite dans ce guide, les espaces de stockage direct s’intègrent parfaitement aux fonctionnalités que vous connaissez aujourd’hui et qui composent la pile de stockage à définition logicielle Windows Server, dont le système de fichiers de volumes partagés de cluster (CSVFS), les espaces de stockage et le clustering de basculement.

Le scénario de déploiement hyper-convergé présente les composants Hyper-V (calcul) et des espaces de stockage direct (stockage) sur le même cluster. Les fichiers de la machine virtuelle sont stockés sur des volumes partagés de cluster locaux. Cela permet la mise à l’échelle des clusters de calcul Hyper-V avec le stockage qu’il utilise. Une fois les espaces de stockage direct configurés et les volumes partagés de cluster disponibles, la configuration et la mise en service d’Hyper-V suivent le même processus et utilisent les mêmes outils que pour tout autre déploiement Hyper-V sur un cluster de basculement.

La figure 1 illustre le scénario de déploiement hyper-convergé.

FIGURE 1 : Hyper-convergé - même cluster configuré pour l’hébergement de machines virtuelles et les espaces de stockage direct

Les informations suivantes seront nécessaires comme entrées pour configurer, mettre en service et gérer le système hyper-convergé. Par conséquent, elles accéléreront et faciliteront le processus si vous les avez à votre disposition quand vous commencez :

-

Noms des serveurs Vous devez être familiarisé avec les stratégies de noms de votre organisation pour les ordinateurs, les fichiers, les chemins et d’autres ressources. En effet, vous allez mettre en service plusieurs serveurs, et chaque élément doit avoir un nom unique.

-

Nom du domaine Vous allez joindre des ordinateurs de votre domaine, et vous devrez spécifier le nom du domaine. Il est recommandé de vous familiariser avec vos stratégies internes de jonction de domaine et d’attribution de noms de domaines.

-

Pour les configurations RDMA :

-

Marque/modèle de commutateur TOR (Top of Rack) (requis lors de l’utilisation de cartes réseau RoCE v2)

-

Marque/modèle de carte réseau

Il existe 2 types de protocoles RDMA. Notez quel est le type de votre carte RDMA (v2 ou iWarp).

-

ID de réseau local virtuel à utiliser pour les deux interfaces réseau utilisées par le système d’exploitation de gestion sur les hôtes hyper-convergés. Vous devriez pouvoir l’obtenir auprès de votre administrateur réseau.

- Package de service KB3157663 Ce package contient des mises à jour qui sont importantes pour avoir les nœuds hyper-convergés, ainsi que tout serveur gérant un déploiement hyper-convergé Windows Server 2016.

Options d'installation

Les déploiements hyper-convergés peuvent être effectués à l’aide d’une installation Nano Server, d’une installation minimale ou d’une installation Serveur avec Expérience utilisateur pour Windows Server 2016. Nano Server est une nouvelle option d’installation pour Windows Server 2016. Pour plus d’informations sur les avantages de l’utilisation de Nano Server, ainsi que du déploiement et de la gestion de Nano Server, voir la page Prise en main de Nano Server.

Ce guide est consacré au déploiement de systèmes hyper-convergés à l’aide de l’option d’installation minimale.

Toutefois, les étapes décrites dans les sections « Configurer le réseau » et « Configurer les espaces de stockage direct » sont identiques, que vous utilisiez l’installation Serveur avec Expérience utilisateur, l’installation minimale ou l’installation Nano Server.

Système de gestion

Dans le cadre de ce billet, l’ordinateur sur lequel se trouvent les outils de gestion pour gérer le cluster localement ou à distance est appelé « système de gestion ». La configuration requise pour l’ordinateur du système de gestion est la suivante :

-

Exécution de Windows Server 2016 avec les mêmes mises à jour que celles des serveurs qu’il gère et joint au même domaine ou à un domaine entièrement fiable.

-

Outils d’administration de serveur distant et modules PowerShell pour Hyper-V et le clustering de basculement. Les Outils d’administration de serveur distant et les modules PowerShell sont disponibles sur Windows Server 2016, et peuvent être installés sans installer d’autres fonctionnalités.

-

Le système de gestion peut être exécuté à l’intérieur d’une machine virtuelle ou sur un ordinateur physique.

-

Nécessite une connectivité réseau aux serveurs qu’il gère.

Étape 1 : Déployer Windows Server

Quand vous installez Windows Server 2016 à l’aide de l’Assistant Installation, il se peut que vous puissiez choisir entre Windows Server 2016 et Windows Server 2016 (Serveur avec Expérience utilisateur). L’option Serveur avec Expérience utilisateur est l’équivalent Windows Server 2016 de l’option d’installation complète disponible dans Windows Server 2012 R2 avec la fonctionnalité Expérience utilisateur installée. Si vous n’effectuez pas de choix dans l’Assistant Installation, Windows Server 2016 est installé avec l’option d’installation minimale. Cette option requiert moins d’espace disque, diminue la surface exposée aux attaques et réduit considérablement les tâches de maintenance. Pour toutes ces raisons, nous vous recommandons de choisir l’installation minimale si vous n’avez pas besoin d’utiliser les éléments d’interface utilisateur et les outils de gestion graphiques que l’option Serveur avec Expérience utilisateur fournit en plus.

Pour plus d’informations sur ces deux options d’installation, voir Installation Options for Windows Server 2016 (Options d’installation pour Windows Server 2016). Pour plus d’informations sur le déploiement de Windows Server 2016 dans le cadre d’une installation minimale, voir Installation minimale.

Étape 1.1 : Établir la connexion aux nœuds de cluster

Vous aurez besoin d’un système de gestion disposant de Windows Server 2016 avec la même configuration que celle des nœuds de cluster et les mêmes mises à jour à gérer. S’il s’agit d’un déploiement Serveur avec Expérience utilisateur, vous pouvez le gérer à partir d’un ordinateur distant ou en vous connectant à l’un des nœuds de cluster. Vous pouvez également utiliser un ordinateur client Windows 10 sur lequel sont installés les dernières mises à jour et les Outils d’administration de serveur distant clients pour Windows Server 2016.

-

Sur le système de gestion, installez le cluster de basculement et les outils de gestion Hyper-V. Vous pouvez effectuer cette opération à l’aide du Gestionnaire de serveur en utilisant l’Assistant Ajout de rôles et de fonctionnalités. Dans la page Fonctionnalités, sélectionnez Outils d’administration de serveur distant, puis sélectionnez les outils à installer.

Ouvrez une session PowerShell avec des privilèges d’administrateur et exécutez la commande suivante. Cette opération configure les hôtes approuvés sur tous les hôtes.

Set-Item WSMan:\localhost\Client\TrustedHosts "*"

Après la configuration exceptionnelle ci-dessus, il ne sera pas nécessaire de répéter Set-Item. Toutefois, chaque fois que vous fermez puis rouvrez la console PowerShell, vous devez établir une nouvelle session PowerShell à distance au serveur en exécutant les commandes ci-dessous :

-

Ouvrez la session PowerShell, puis utilisez le nom du serveur ou l’adresse IP du nœud auquel vous souhaitez vous connecter. Après avoir exécuté cette commande, vous êtes invité à entrer un mot de passe. Entrez le mot de passe d’administrateur que vous avez spécifié lors de l’installation de Windows.

Enter-PSSession -ComputerName <myComputerName> -Credential LocalHost\Administrator

Exemples d’exécution de la même chose d’une façon plus utile dans les scripts, au cas où vous devriez effectuer cette opération plusieurs fois :

Exemple 1 : en utilisant une adresse IP :

$ip = "10.100.0.1"

$user = "$ip\Administrator"

Enter-PSSession -ComputerName $ip -Credential $user

Exemple 2 : OU vous pouvez faire de même avec le nom de l’ordinateur à la place de l’adresse IP.

$myServer1 = "myServer-1"

$user = "$myServer1\Administrator"

Enter-PSSession -ComputerName $myServer1 -Credential $user

Étape 1.2 : Ajouter des comptes de domaine

Jusqu’à présent, ce guide vous a fait déployer et configurer des nœuds individuels avec le compte Administrateur local <Nom_ordinateur>\Administrator.

La gestion d’un système hyper-convergé, notamment des composants de cluster, de stockage et de virtualisation, nécessite souvent l’utilisation d’un compte de domaine qui fait partie du groupe Administrateurs sur chaque nœud.

Appliquez les étapes suivantes à partir du système de gestion :

- Sur le système de gestion, ouvrez une console PowerShell avec des privilèges d’administrateur.

-

Utilisez la commande Enter-PSSession pour vous connecter à chaque nœud, puis exécutez la commande suivante pour ajouter votre ou vos comptes de domaine au groupe de sécurité local Administrateurs. Consultez la section ci-dessus pour obtenir des informations sur la façon de se connecter aux serveurs à l’aide de PSSession.

Net localgroup Administrators <Domain\Account> /add

Les espaces de stockage direct nécessitent des connexions réseau à bande passante élevée et faible latence entre les nœuds. Cette connectivité réseau est essentielle pour assurer les performances et la fiabilité du système. Il est recommandé de disposer d’au moins 2 connexions de 10 Go entre les nœuds. L’accès RDMA est également recommandé, car il offre un débit beaucoup plus élevé et réduit l’utilisation du processeur pour le trafic réseau.

Il existe deux versions courantes de cartes réseau RDMA. RoCE et iWARP. Vous pouvez les utiliser avec des espaces de stockage direct si elles présentent le logo Windows Server 2016. Les commutateurs TOR (Top of Rack) et configurations de serveur peuvent varier selon le commutateur et la carte réseau. Il est essentiel de configurer le serveur et le commutateur correctement pour assurer la fiabilité et les performances des espaces de stockage direct.

Windows Server 2016 introduit également un commutateur virtuel avec la fonctionnalité d’association incorporée de commutateurs SET (Switch Embedded Teaming). Ce nouveau commutateur virtuel permet d’utiliser les 2 mêmes ports de carte réseau physique pour les machines virtuelles et la partition parente du serveur pour bénéficier de la connectivité RDMA. Ceci réduit le nombre de ports de carte réseau physique requis et permet de gérer la mise en réseau à travers les fonctionnalités SDN (Software Defined Network) de Windows Server 2016. Les étapes décrites dans ce guide concernent l’implémentation du nouveau commutateur virtuel avec la connectivité RDMA activée pour la partition parente et la fonctionnalité SET configurée.

La procédure suivante suppose que vous disposez de 2 ports de carte réseau physique RDMA (1 port double ou 2 ports simples) et d’un commutateur Hyper-V déployé avec des cartes réseau virtuelles d’hôtes compatibles RDMA. Effectuez les étapes suivantes pour configurer le réseau sur chaque serveur.

Ignorer cette section Configuration du réseau si vous testez des espaces de stockage direct à l’intérieur des machines virtuelles. RDMA n’est pas disponible pour la mise en réseau à l’intérieur d’une machine virtuelle.

Notre exemple de configuration utilise une carte réseau qui implémente RDMA à l’aide de RoCEv2. La qualité de service (QoS) réseau et la fiabilité du flux de données pour ce type de RDMA exigent que le commutateur TOR ait des fonctionnalités spécifiques définies pour les ports réseau auxquels les cartes réseau sont connectées. Si vous effectuez le déploiement avec iWarp, il se peut que le commutateur TOR ne requière pas de configuration.

Étape 2.2 : Activer la qualité de service réseau (QoS)

La QoS réseau est utilisée dans cette configuration hyper-convergée pour vérifier que le système de stockage à définition logicielle dispose de suffisamment de bande passante pour la communication entre les nœuds afin de garantir la résilience et les performances. Effectuez les étapes suivantes à partir d’un système de gestion en utilisant Enter-PSSession pour vous connecter, et exécutez les opérations suivantes sur chacun des serveurs.

-

Définissez une stratégie QoS réseau pour SMB Direct, qui est le protocole utilisé par le système de stockage à définition logicielle.

New-NetQosPolicy “SMB” –NetDirectPortMatchCondition 445 –PriorityValue8021Action 3

La sortie doit ressembler à ceci :

Name : SMB

Owner : Group Policy (Machine)

NetworkProfile : All

Precedence : 127

JobObject :

NetDirectPort : 445

PriorityValue :

-

Si vous utilisez RoCEv2, activez le contrôle de flux pour SMB comme suit (non requis pour iWarp) :

Enable-NetQosFlowControl –Priority 3

-

Désactivez le contrôle de flux pour le reste du trafic comme suit (facultatif pour iWarp) :

Disable-NetQosFlowControl –Priority 0,1,2,4,5,6,7

-

Obtenez une liste des cartes réseau pour identifier les cartes cibles (cartes RDMA) comme suit :

Get-NetAdapter | FT Name,InterfaceDescription,Status,LinkSpeed

La sortie doit ressembler à ce qui suit. Les cartes ConnectX-3 Pro Mellanox sont les cartes réseau RDMA, et sont les seules connectées à un commutateur dans cet exemple de configuration.

Name InterfaceDescription Status LinkSpeed

---- --------------------------------------------------------- ---------- ----------

NIC3 QLogic BCM57800 Gigabit Ethernet (NDIS VBD Client)

Ethernet 2 Mellanox ConnectX-3 Pro Ethernet Adapter

SLOT

NIC4 QLogic BCM57800 Gigabit Ethernet (NDIS VBD Client)

NIC1 QLogic BCM57800 10 Gigabit Ethernet (NDIS VBD Client)

NIC2 QLogic BCM57800 10 Gigabit Ethernet (NDIS VBD Client)

-

Appliquez la stratégie QoS réseau aux cartes cibles. Les cartes cibles sont les cartes RDMA. Utilisez le « Nom » des cartes cibles pour la valeur -InterfaceAlias dans l’exemple suivant :

Enable-NetAdapterQos –InterfaceAlias “<adapter1>”,”<adapter2>”

Si vous utilisez l’exemple ci-dessus, la commande se présente ainsi :

Enable-NetAdapterQoS –InterfaceAlias “Ethernet 2”,”SLOT

-

Créez une classe de trafic et donnez à SMB Direct au minimum 30 % de la bande passante. Le nom de la classe sera « SMB ».

New-NetQosTrafficClass “SMB” –Priority 3 –BandwidthPercentage 30 –Algorithm ETS

Étape 2.3 : Créer un commutateur virtuel Hyper-V

Le commutateur virtuel Hyper-V permet d’utiliser les ports de carte réseau physique à la fois pour les ordinateurs hôtes et les machines virtuelles, et active RDMA à partir de l’hôte, ce qui offre davantage de débit, moins de latence et moins d’impact sur le système (processeur). Les interfaces réseau physiques sont associées à l’aide de la fonctionnalité d’association incorporée de commutateurs SET (Switch Embedded Teaming), qui est une nouveauté de Windows Server 2016.

Effectuez les étapes suivantes à partir d’un système de gestion en utilisant Enter-PSSession pour vous connecter à chacun des serveurs.

-

Identifiez les cartes réseau (vous allez utiliser ces informations à l’étape #2).

Get-NetAdapter | FT Name,InterfaceDescription,Status,LinkSpeed

-

Créez le commutateur virtuel connecté aux deux cartes réseau physiques, puis activez la fonctionnalité SET (Switch Embedded Teaming). Vous pouvez remarquer un message indiquant que la connexion à votre session PowerShell (PSSession) a été perdue. Ce comportement est attendu et votre session se reconnectera.

New-VMSwitch –Name SETswitch –NetAdapterName “<adapter1>”,"<adapter2>" –EnableEmbeddedTeaming $true

-

Ajoutez des cartes réseau virtuelles hôtes au commutateur virtuel. Cette opération configure une carte réseau virtuelle (vNIC) à partir du commutateur virtuel que vous venez de configurer pour la gestion du système d’exploitation à utiliser.

Add-VMNetworkAdapter –SwitchName SETswitch –Name SMB_1 –managementOS

Add-VMNetworkAdapter –SwitchName SETswitch –Name SMB_2 –managementOS

-

Configurez les cartes réseau virtuelles hôtes pour utiliser un réseau local virtuel. Elles peuvent se trouver sur le même réseau local virtuel ou sur des réseaux locaux virtuels différents.

Set-VMNetworkAdapterVlan -VMNetworkAdapterName "SMB_1" -VlanId <vlan number> -Access -ManagementOS

Set-VMNetworkAdapterVlan -VMNetworkAdapterName "SMB_2" -VlanId <vlan number> -Access -ManagementOS

-

Vérifiez que l’ID de réseau local virtuel (VLANID) est défini.

Get-VMNetworkAdapterVlan –ManagementOS

La sortie doit ressembler à ceci :

VMName VMNetworkAdapterName Mode VlanList

SMB_1 Access 13

SETswitch Untagged

SMB_2 Access 13

-

Redémarrez chaque adaptateur de carte réseau virtuelle hôte afin que le réseau local virtuel soit actif.

Restart-NetAdapter “vEthernet (SMB_1)”

Restart-NetAdapter “vEthernet (SMB_2)”

-

Activez RDMA sur les adaptateurs de cartes réseau virtuelles hôtes.

Enable-NetAdapterRDMA “vEthernet (SMB_1)”,”vEthernet (SMB_2)”

-

Associez chaque carte réseau virtuelle configurée pour RDMA à une carte physique connectée au commutateur virtuel.

Set-VMNetworkAdapterTeamMapping -VMNetworkAdapterName 'SMB_1' –ManagementOS –PhysicalNetAdapterName 'SLOT 2'

Set-VMNetworkAdapterTeamMapping -VMNetworkAdapterName 'SMB_2' –ManagementOS –PhysicalNetAdapterName 'SLOT 2 2'

-

Vérifiez les fonctions RDMA.

Get-SmbClientNetworkInterface

Les valeurs doivent afficher True pour l’option Compatible RDMA pour les interfaces compatibles RDMA. Voici un exemple où vous affichez true pour les cartes vEthernet (SMB_1) et vEthernet (SMB_2).

Les étapes suivantes sont effectuées sur un système de gestion qui est de la même version que les serveurs en cours de configuration. Les étapes suivantes ne doivent PAS être effectuées à distance à l’aide d’une session PowerShell (PSSession), mais dans une session PowerShell locale sur le système de gestion, avec des autorisations administratives.

Étape 3.1 : Exécuter la validation du cluster

Dans cette étape, vous allez exécuter l’outil de validation du cluster pour garantir que les nœuds de serveur sont correctement configurés pour créer un cluster à l’aide d’espaces de stockage direct. Quand la validation du cluster (Test-Cluster) est exécutée avant la création du cluster, elle exécute les tests qui vérifient que la configuration est appropriée pour fonctionner correctement comme cluster de basculement. L’exemple ci-dessous utilise le paramètre « -Include », puis les catégories de tests spécifiques sont définies. Cela garantit que les tests spécifiques des espaces de stockage direct sont inclus dans la validation.

Utilisez la commande PowerShell suivante pour valider un ensemble de serveurs à utiliser comme cluster d’espaces de stockage direct.

Test-Cluster –Node <MachineName1,MachineName2,MachineName3,MachineName4> –Include “Storage Spaces Direct”,”Inventory”,”Network”,”System Configuration”

Étape 3.2 : Créer un cluster

Dans cette étape, vous allez créer un cluster avec les nœuds que vous avez validés pour la création du cluster à l’étape précédente à l’aide de l’applet de commande PowerShell suivante. Il est important d’ajouter le paramètre –NoStorage à l’applet de commande ; sinon, des disques peuvent être automatiquement ajoutés au cluster et vous devrez les supprimer avant d’activer les espaces de stockage direct, sans quoi ils ne seront pas inclus dans le pool de stockage des espaces de stockage direct.

Lors de la création du cluster, vous obtiendrez un avertissement indiquant : « Des problèmes se sont produits lors de la création du rôle en cluster. Celui-ci peut ne pas démarrer. Pour de plus amples informations, consultez le fichier de rapport ci-dessous. » Vous pouvez ignorer cet avertissement en toute sécurité. Cela est dû au fait qu’aucun disque n’est disponible pour le quorum du cluster. Il est recommandé de configurer un témoin de partage de fichiers ou un témoin de cloud après la création du cluster.

Remarque

Si les serveurs utilisent des adresses IP statiques, modifiez la commande suivante afin de refléter l’adresse IP statique en ajoutant le paramètre suivant et en spécifiant l’adresse IP : –StaticAddress <X.X.X.X>. Dans la commande suivante, l’espace réservé ClusterName doit être remplacé par un nom NetBIOS unique et d’au maximum 15 caractères.

New-Cluster –Name <ClusterName> –Node <MachineName1,MachineName2,MachineName3,MachineName4> –NoStorage

Une fois le cluster créé, la réplication de l’entrée DNS pour le nom du cluster peut demander du temps. Cette durée dépend de l’environnement et la configuration de la réplication DNS. Si la résolution du cluster échoue, dans la plupart des cas, vous pouvez réussir en utilisant le nom d’ordinateur d’un nœud qui est un membre actif du cluster à la place du nom du cluster.

Il est recommandé de configurer un témoin pour le cluster, afin qu’un système à 3 nœuds (ou plus) puisse faire face à l’échec ou à la mise hors connexion de deux nœuds. Un déploiement à 2 nœuds requiert un témoin de cluster. Sinon, en cas de mise hors connexion de l’un des nœuds, l’autre ne sera plus disponible non plus. Avec ces systèmes, vous pouvez utiliser un partage de fichiers en tant que témoin, ou utiliser un témoin de cloud. Pour plus d’informations, voir Déployer un témoin de cloud pour un cluster de basculement.

Pour plus d’informations sur la configuration d’un témoin de partage de fichiers, voir Configuring a File Share Witness on a Scale-Out File Server (Configuration d’un témoin de partage de fichiers sur un serveur de fichiers avec montée en puissance parallèle).

Étape 3.4 : Nettoyer les disques

Les disques destinés à être utilisés pour les espaces de stockage direct doivent être vides et sans partitions ou autres données. Si un disque contient des partitions ou d’autres données, il ne sera pas inclus dans le système d’espaces de stockage direct.

Sur le système de gestion, ouvrez une fenêtre PowerShell ISE avec des privilèges d’administrateur, puis créez et exécutez le script suivant en remplaçant la variable <ClusterName> par le nom de cluster approprié. L’exécution de ce script permet d’identifier les disques sur chaque nœud qui peuvent être utilisés pour les espaces de stockage direct, et supprime toutes les données et partitions de ces disques.

Vous pouvez ignorer cette étape si les disques ont déjà été nettoyés ou vérifiés comme ne comportant pas de partitions.

Important

Vérifiez qu’il n’y a pas de données sur l’un des disques du cluster avant d’exécuter cet ensemble de commandes. Il supprime toutes les données sur les disques qui ne sont pas en cours d’utilisation par le système d’exploitation.

icm (Get-Cluster -Name <cluster or node name> | Get-ClusterNode) {

Update-StorageProviderCache

Get-StoragePool | ? IsPrimordial -eq $false | Set-StoragePool -IsReadOnly:$false -ErrorAction SilentlyContinue

Get-StoragePool | ? IsPrimordial -eq $false | Get-VirtualDisk | Remove-VirtualDisk -Confirm:$false -ErrorAction SilentlyContinue

Get-StoragePool | ? IsPrimordial -eq $false | Remove-StoragePool -Confirm:$false -ErrorAction SilentlyContinue

Get-PhysicalDisk | Reset-PhysicalDisk -ErrorAction SilentlyContinue

Get-Disk | ? Number -ne $null | ? IsBoot -ne $true | ? IsSystem -ne $true | ? PartitionStyle -ne RAW | % {

$_ | Set-Disk -isoffline:$false

$_ | Set-Disk -isreadonly:$false

$_ | Clear-Disk -RemoveData -RemoveOEM -Confirm:$false

$_ | Set-Disk -isreadonly:$true

$_ | Set-Disk -isoffline:$true

}

Get-Disk |? Number -ne $null |? IsBoot -ne $true |? IsSystem -ne $true |? PartitionStyle -eq RAW | Group -NoElement -Property FriendlyName

} | Sort -Property PsComputerName,Count

La sortie du script doit ressembler à ce qui suit. La valeur Count représente le nombre de disques portant ce nom par nœud de cluster (PSComputerName) :

Count Name PSComputerName

4 ATA SSDSC2BA800G4n StorageClusterNode1

10 ATA ST4000NM0033 StorageClusterNode1

4 ATA SSDSC2BA800G4n StorageClusterNode1

10 ATA ST4000NM0033 StorageClusterNode1

4 ATA SSDSC2BA800G4n StorageClusterNode1

10 ATA ST4000NM0033 StorageClusterNode1

4 ATA SSDSC2BA800G4n StorageClusterNode1

10 ATA ST4000NM0033 StorageClusterNode1

Étape 3.5 : Activer les espaces de stockage direct

Après avoir créé le cluster, utilisez l’applet de commande PowerShell Enable-ClusterStorageSpacesDirect, qui placera le système de stockage en mode d’espaces de stockage direct et effectuera automatiquement les opérations suivantes :

-

Créer un pool : crée un seul pool volumineux qui porte un nom semblable à « S2D sur Cluster1 ».

-

Configurer les caches des espaces de stockage direct : si plusieurs types de média (lecteur) sont disponibles pour l’utilisation des espaces de stockage direct, les plus rapides en tant que périphériques cache sont activés (en lecture et en écriture dans la plupart des cas).

-

Niveaux : crée deux niveaux comme niveaux par défaut. L’un est appelé « Capacité » et l’autre est appelé « Performances ». L’applet de commande analyse les périphériques et configure chaque niveau avec une combinaison de types de périphériques et de résilience.

À partir du système de gestion, dans une fenêtre de commande PowerShell ouverte avec des privilèges d’administrateur, lancez la commande suivante. Le nom de cluster est celui du cluster que vous avez créé aux étapes précédentes. Si cette commande est exécutée localement sur l’un des nœuds, le paramètre -CimSession n’est pas nécessaire.

Enable-ClusterStorageSpacesDirect –CimSession <ClusterName>

Pour activer les espaces de stockage direct à l’aide de la commande ci-dessus, vous pouvez également utiliser le nom du nœud à la place du nom du cluster. L’utilisation du nom du nœud peut être plus fiable en raison de retards de réplication DNS qui peuvent se produire avec le nom du cluster nouvellement créé.

Quand l’exécution de cette commande est terminée, ce qui peut prendre plusieurs minutes, le système est prêt pour la création de disques virtuels.

Étape 3.6 : Créer des volumes

Quand la fonctionnalité des espaces de stockage direct a été activée, elle a créé un pool unique à l’aide de tous les disques et a attribué à ce pool un nom semblable à « S2D sur Cluster1 », en spécifiant le nom du cluster actif sur le nom. Par conséquent, l’étape suivante consiste à créer des volumes, en spécifiant s’il convient d’utiliser plusieurs niveaux.

Les espaces de stockage direct offrent la possibilité de créer un disque virtuel avec des niveaux utilisant des types de résilience différents. L’exemple ci-dessous définit le disque virtuel de façon à créer un niveau avec miroir triple et double parité. Cela optimise les écritures sur le miroir pour les performances et les écritures en parité en arrière-plan quand il est nécessaire d’optimiser l’utilisation du disque physique. Pour identifier les niveaux sur le système, vous pouvez utiliser l’applet de commande Get-StorageTier dans une session PowerShell (PSSession) sur l’un des nœuds du cluster.

Important

Gardez suffisamment de capacité disponible dans le pool de stockage pour autoriser une défaillance de disque et conserver la possibilité de réparer les disques virtuels avec les autres disques. Par exemple, si vous disposez de 20 disques de 2 To et que vous souhaitez autoriser 1 défaillance de disque avec réparation automatique des disques virtuels, vous devez créer un volume qui laisse une capacité disponible minimale de 2 To dans le pool de stockage. Si vous allouez la totalité de la capacité du pool aux disques virtuels, en cas de défaillance d’un disque, les disques virtuels ne pourront pas être réparés tant que le disque défaillant n’est pas remplacé ou que de nouveaux disques ne sont pas ajoutés au pool.

La commande PowerShell suivante crée un disque virtuel avec deux niveaux (miroir et parité) à partir d’un système de gestion :

New-Volume -StoragePoolFriendlyName “S2D*” -FriendlyName <VirtualDiskName> -FileSystem CSVFS_ReFS -StorageTierfriendlyNames Capacity,Performance -StorageTierSizes <Size of capacity tier in size units, example: 800GB>, <Size of Performance tier in size units, example: 80GB> –CimSession <ClusterName>

La commande PowerShell suivante crée un disque virtuel avec uniquement la résilience en miroir :

New-Volume -StoragePoolFriendlyName “S2D*” -FriendlyName <VirtualDiskName> -FileSystem CSVFS_ReFS -StorageTierfriendlyNames Performance -StorageTierSizes <Size of Performance tier in size units, example: 800GB> –CimSession <ClusterName>

L’applet de commande New-Volume simplifie les déploiements, car elle établit un lien entre une longue liste d’opérations qui, sans cela, seraient effectuées dans des commandes individuelles telles que la création du disque virtuel, le partitionnement et le formatage du disque virtuel, l’ajout du disque virtuel au cluster, ainsi que sa conversion en système de fichiers CSV (CSVFS).

Étape 3.7 : Déployer des machines virtuelles

À ce stade, vous pouvez mettre en service des machines virtuelles sur les nœuds du cluster d’espaces de stockage direct hyper-convergé.

Les fichiers de la machine virtuelle doivent être stockés dans l’espace de noms CSV du système (par exemple : c:\ClusterStorage\Volume1) exactement comme les machines virtuelles en cluster sur les clusters de basculement.

Vous pouvez utiliser les outils fournis ou d’autres outils pour gérer le stockage et les machines virtuelles, notamment System Center Virtual Machine Manager.

DÉFINITIONS

Matériel réseau : les espaces de stockage direct reposent sur un réseau pour la communication entre les hôtes. Pour les déploiements en production, il est nécessaire d’avoir une carte réseau prenant en charge RDMA (ou une paire de ports de carte réseau).

Matériel de stockage : le système de stockage consiste en un minimum de quatre nœuds de stockage avec un stockage local. Chaque nœud de stockage peut avoir des disques internes ou des disques dans un boîtier JBOD connecté à un disque SAS externe. Les périphériques de disque peuvent être des disques SATA, NVMe ou SAS.

Bus de stockage des logiciels : le bus de stockage des logiciels est le composant logiciel spécifique aux espaces de stockage direct qui s’étend sur tous les nœuds de stockage et réunit le stockage local de chaque nœud afin que tous les disques soient visibles pour la couche des espaces de stockage supérieure. Pour plus d’informations sur le bus de stockage des logiciels, consultez Présentation du bus de stockage des logiciels.

Pool de stockage : le pool de stockage couvre le stockage local sur tous les nœuds.

Espaces de stockage : les espaces de stockage (également appelés disques virtuels) offrent une résilience aux défaillances de nœud ou de disque, car les copies de données sont stockées sur différents nœuds de stockage.

Système de fichiers ReFS (Resilient File System) : ReFS fournit le système de fichiers dans lequel les fichiers de machine virtuelle Hyper-V sont stockés. ReFS est un système de fichiers primordial pour les déploiements virtualisés et inclut des optimisations pour les espaces de stockage telles que la détection d’erreurs et la correction automatique. En outre, ReFS permet d’accélérer des opérations de disques VHD(X) comme la création de disques VHD(X) fixes, l’augmentation de disques VHD(X) dynamiques et la fusion de disques VHD(X).

Volumes partagés de cluster : le système de fichiers de volumes partagés de cluster se situe au-dessus du système ReFS pour regrouper tous les volumes montés en un seul espace de noms accessible via n’importe quel nœud.